Hosting WordPress preinstallato e gestito con il 50% di sconto. Scopri la promo

Un tempo per analizzare le statistiche di scansione del crawler c’era un’unica soluzione: approfittare del grafico poco dettagliato dell’ex Google Webmaster tool che indicava poco e niente: numero di Kb scaricati ogni giorno, tempo impiegato, passaggi del crawler (o spider) sulle pagine del dominio di riferimento. E basta così.

Poi siamo passati lentamente alla nuova versione della Search Console ma gli strumenti per l’analisi del crawler, il programma che passa sul sito web per riportare nella serp ciò che hai pubblicato, sono rimasti in disparte.

Fino a quando non è stato deciso di integrare il tutto. Oggi possiamo finalmente analizzare le statistiche di scansione del crawler nella Search Console. Ma facciamo un passo indietro e scopriamo qualcosa in più.

Argomenti

Si tratta dell’attività svolta dal motore di ricerca, attraverso programmi specifici, per scoprire i vari elementi che compongono il web. Vale a dire i siti web, gli ecommerce e i portali.

Questa è la fase che precede l’indicizzazione e il posizionamento: prima di far comparire un sito web nelle serp, Google scansiona il sito con uno spider. Vale a dire un software di crawling che analizza il tuo lavoro. Ecco di cosa stiamo parlando e perché è importante: presentare il sito web nel miglior modo possibile è il primo passo.

Questo, ovviamente, per avere una buona indicizzazione e un posizionamento adeguato. Attraverso il processo che mi consente di analizzare le statistiche di scansione del crawler posso capire se si sono problemi.

Da leggere: eliminare una pagina web dal motore di ricerca

Una serie di informazioni preziose delle attività svolte dal Googlebot. In primo luogo puoi ottenere il numero di pagine sottoposte a scansione ogni giorno e capire se ci sono problemi: un buon risultato è avere la scansione completa di tutte le pagine ogni giorno, ma è difficile avere questo con un sito di grandi dimensioni.

In ogni caso questo è un valore limitato perché devi considerare anche il numero di Kb scaricati ogni giorno per capire il peso medio dei file scaricati (che possono essere documenti HTML, immagini, PDF, CSS, Javascript).

Il tempo di download è il parametro per capire quanto impegno ci mette Google per svolgere il suo lavoro, in questo modo puoi lavorare sulla velocizzazione e ottimizzare il crawl budget per semplificare il lavoro del Googlebot che dovrebbe passare con maggior frequenza sul tuo sito web. Questo avviene anche con un hosting di qualità.

Ci sono una serie di tool molto interessanti che ti possono aiutare nell’opera di analisi dei risultati quando si parla di crawling. Screaming Frog è il primo emulatore che viene in mente a qualsiasi esperto SEO per riprodurre il comportamento di un Googlebot e scoprire come si presenta un sito web con tanto di log analizer.

Semrush offre uno strumento simile che consente di studiare il comportamento di un ipotetico crawler e lo stesso vale per Ahrefs. A questi si aggiungono Visual SEO Studio, Deepcrawl, Cocoscan e Sitebulb.

Ma è ovvio che i risultati migliori arrivano solo dai dati raccolti da Google. Ed è chiaro che con la nuova versione della Search Console i dati sono decisivi. Ecco cosa devi sapere per avere maggiori informazioni.

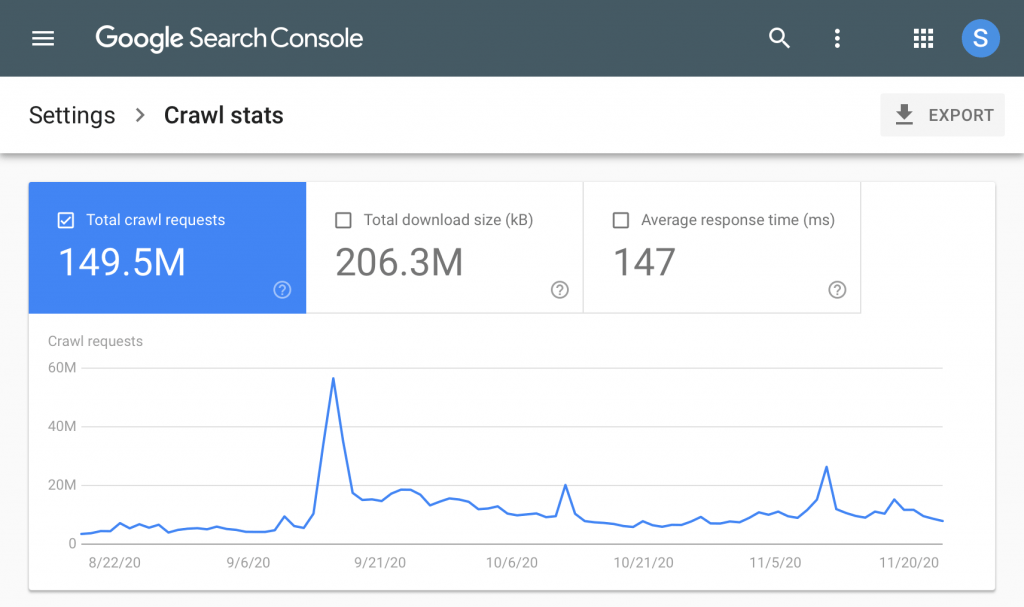

Vuoi uno strumento chiaro ed efficace per analizzare le statistiche di scansione del crawler? Il rapporto statistiche di scansione nella Search Console offe diverse funzionalità. Nel grafico temporale hai già quello che ti serve.

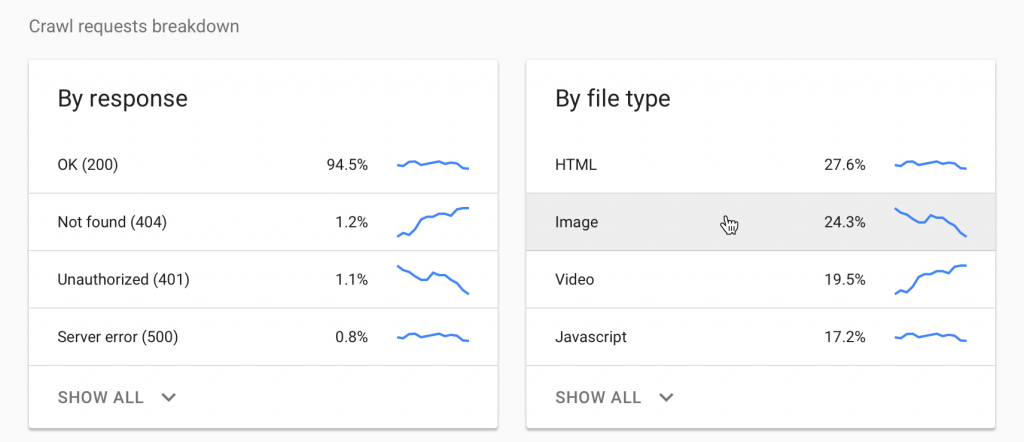

Qui puoi iniziare a visualizzare i dati di scansione di Google e i grafici che riuniscono richieste totali, dimensioni del download e tempo di risposta medio. La nuova versione del rapporto fornisce informazioni sul numero totale di richieste raggruppate per codice di risposta, tipo di file sottoposto a scansione, scopo della scansione e tipo di bot.

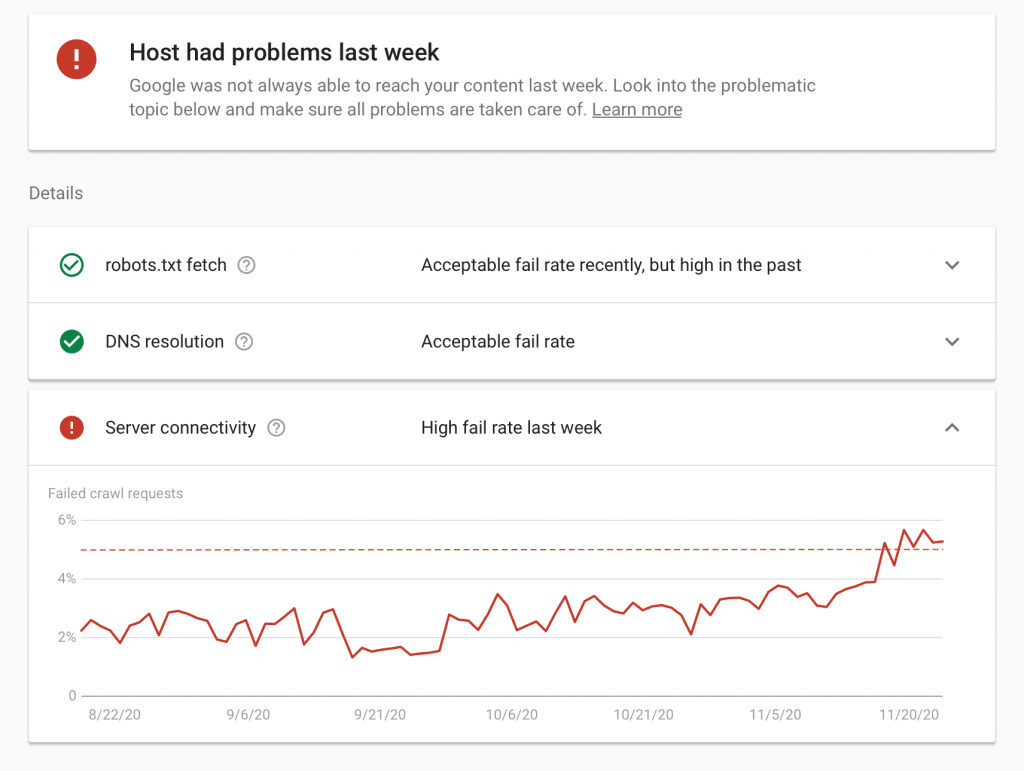

Poi hai esempi di URL per mostrare dove si sono verificate le richieste del sito, un riepilogo per proprietà e le informazioni sullo stato dell’host. Questa è una novità molto interessante per verificare uptime e downtime del sito web, la sua disponibilità per i tuoi clienti. In sintesi, il nuovo rapporto sulle statistiche di scansione è speciale.

Perché ti aiuta a capire come Googlebot esegue la scansione del tuo sito. Questo avviene attraverso la cronologia di scansione, i tipi di file e le dimensioni restituite dal tuo sito, i dettagli delle richieste e i problemi di disponibilità.